Der halboffene Haushalt

In The state of mapping APIs wirft Adam DuVander einen Blick auf die wichtigsten momentan verfügbaren Mapping APIs (vergisst dabei aber OpenLayers!). Er stellt fest, dass es immer einfacher werde, Karten zu erstellen, dass es aber immer noch zu schwierig sei, an die Daten heranzukommen, um die Karten mit sinnvollen Informationen anzureichern.

In diesem Zusammenhang weist er auch darauf hin, dass es immer noch zu kompliziert sei, so genannte Choroplethenkarten aus Datenquellen zu erstellen. Was ein Choroplethenkarte ist, musste ich erst einmal nachschlagen. Im Prinzip sind das eingefärbte thematische Karten, auf denen beispielsweise Landkreise nach Häufigkeit bestimmer Eigenschaften unterschiedlich eingefärbt werden, wie sie auch dpa Regiodata anbietet. Da kommt dann auch wieder die Open Government-Bewegung ins Spiel.

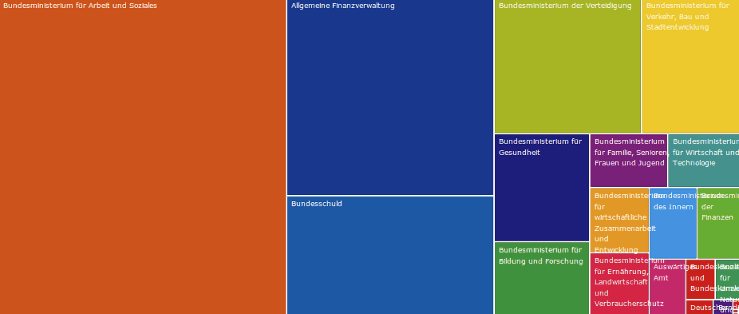

Denn was bringt uns das beste Toolkit, um solche Karten einfach und schnell erstellen zu können, wenn wir an die zugrundeliegenden Daten gar nicht herankommen? Welche Probleme das Fehlen der Daten mit sich bringt, zeigt ein aktuelles Projekt auf. Unter OffenerHaushalt wird der Bundeshaushalt schön visualisiert und interaktiv bis auf die einzelnen Posten heruntergebrochen erfahrbar gemacht. Einen Haken hat die Sache aber, denn:

Die von OffenerHaushalt.de verwendeten Daten entstammen der Webseite des Bundesministeriums der Finanzen. Leider stehen die Haushaltsdaten nicht in einem offenen, maschinenlesbaren Datenformat zur Verfügung. Wir mussten daher auf einer maschinelle Auswertung der angebotenen HTML-Dokumente ("screen scraping") zurückgreifen.

Das ist schon ganz schön bitter und der Qualität der Daten nicht gerade förderlich. Immerhin stellt das Projekt die so gewonnenen Daten in maschinenlesbarer Form zur Verfügung, so dass sie auch von Dritten weiterverarbeitet werden können. Ich würde ja gern auch die Länderhaushalte sehen oder den Bundeshaushalt als multi-level pie chart. Eine freie Library, die so ein Diagramm erzeugen kann, habe ich aber noch nicht gefunden. Mal weitersuchen ...

Nicht vergessen, nächste Woche ist unser nächstes

Nicht vergessen, nächste Woche ist unser nächstes